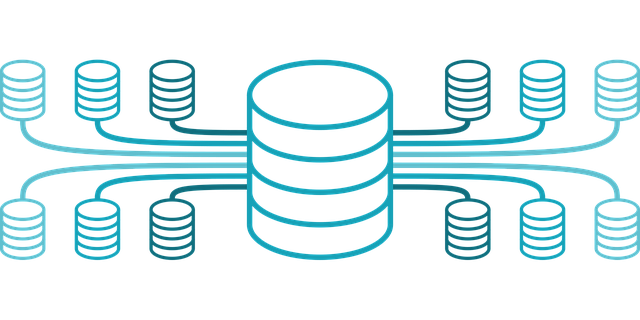

Казалось бы на первый взгляд, банальная задача по установке базы данных Oracle 19с в операционной системе Oracle Linux 8 от одного и того же производителя ПО является тривиальным делом. Однако, к своему удивлению столкнулся с тем, что в этом есть определенные принципиальные сложности, которые не освещены в документации. Как оказалось, в ОС Oracle Linux 8 идет kernel 5.15.x. А данное ядро перестало поддерживать функционал ASMFD, который стандартно используется в базе данных Oracle для доступа к дисковой подсистеме. Подсистема ASM — Automatic Storage Management давно стала неотъемлимой составляющей СУБД Oracle, без которой просто невозможно теперь использовать саму базу данных. Oracle ASMFD или ASM Filter Driver — это самый современный способ, который использует база данных Oracle для доступа к дискам. И вот, как выяснилось, операционная система Oracle Linux 8, которая выпускается корпорацией Oracle не поддерживает из коробки ключевой продукт в виде СУБД Oracle от этой же компании.

Читать далее «СУБД Oracle и OC Oracle Linux 8»